Als data een wezenlijk onderdeel is van jouw businessmodel, dan heb je mensen in dienst die data kunnen vergaren. Vinden zij dat een interessant onderdeel van het werk, of werken ze liever aan analyses en inzichten? In de huidige krappe arbeidsmarkt is het slim om tegemoet te komen aan de wensen van je medewerkers, vandaar dat steeds meer bedrijven zich afvragen wat de gronden zijn om over te gaan op het inkopen van data.

Introductie

De extractie van data van een webpagina lijkt eenvoudig; iemand met kennis van html zoekt op een webpagina naar die elementen die hij/zij graag wil hebben en slaat deze op. Als het gaat om een enkele keer of een aantal websites kan dat prima een tijdje goed gaan.

Als de afhankelijkheid van data groter wordt, wordt het minder eenvoudig en wel om verschillende redenen; websites worden steeds frequenter aangepast en/ of getest, er zijn browser updates, beveiliging issues en problemen met schedulen, data bewerking enzovoorts. Ontwikkelaars werken daarom vaak met tools die hen helpen bij het scrapen.

Wat zijn de opties bij scraping?

1

Zelf tooling laten bouwen

2

Tooling inkopen

3

Scraping uitbesteden/ data inkopen

Ad.1

Zelf tooling laten bouwen

De optie om zelf te bouwen kan voortkomen uit een idee dat alle software (ontwikkeling) inhouse moet zijn. Hiervoor zijn resources nodig met kennis en ervaring en een continue beschikbaarheid voor o.a. het oplossen van fouten. Gaat er een klein dingetje fout, dan is er geen of foute data. Knelpunten hierbij zijn datakwaliteit en continue beschikbaarheid van de data.

Ad.2

Tooling inkopen

Scraping tools zijn relatief goedkoop en er is niet veel technische kennis voor nodig om ze te bedienen. Beschikt de tooling over advanced functionaliteiten, zoals een proxy netwerk, dan is er meer kennis vereist. Qua functionaliteit zijn er enkele belangrijke nadelen te benoemen. Elke tool gebruikt een bepaalde techniek en deze techniek is niet toepasbaar op elke website. Ook is het zo dat zodra een tool bekender wordt, deze gemakkelijker en dus vaker wordt herkend en geblocked. Als dat het geval is, dan kan je niets anders dan wachten op de update voordat je verder kan.

Een ander belangrijk nadeel wat veel tijd kost, is dat er in de gekochte tooling vaak geen “retry” mogelijkheid zit. Dat houdt in dat als een scraping klaar is, er handmatig moet worden uitgezocht wat en of er fouten zijn, deze fouten moeten worden opgezocht en dat gedeelte moet opnieuw worden gedraaid, anders gaat het ten koste van de datakwaliteit. Tenslotte zijn de huidige tools in de (internationale) markt nog steeds vaak desktop tools. Hierbij moet een pc aanstaan en de scrapes moeten handmatig worden gestart en gescheduled, waarbij volume draaien dan lastig is.

Ad.3

Scraping uitbesteden/ data inkopen

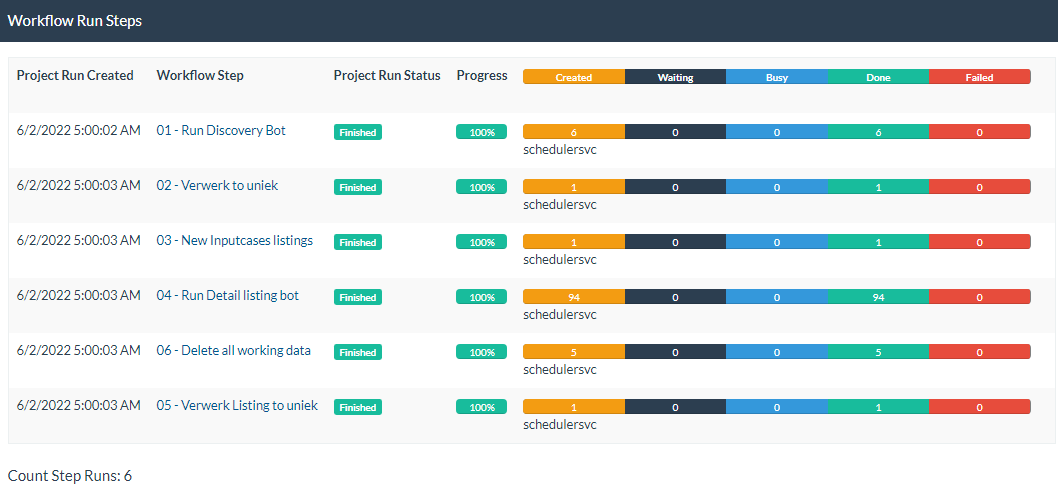

Als de scraping wordt uitbesteedt, dan ontvangt de opdrachtgever periodiek de gewenste data. Ons WSA scraping platform bestaat uit een netwerk van bots met een geavanceerd beheersysteem in de vorm van een webapplicatie. Wij kunnen hiermee snel (maatwerk) bots bouwen en ze op een handige manier beheren. Scheduling, foutafhandeling (inclusief retries) en advanced proxy integratie is standaard.

We hebben de kennis in huis om te kiezen voor de minst belastende manier van scrapen voor de target website/ server: dat noemen wij ethisch scrapen.

Wij monitoren en updaten continue en er zijn resources beschikbaar die de nieuwste technieken kunnen inzetten als er uitdagingen en updates zijn. Hierdoor is datakwaliteit gegarandeerd en de data is altijd beschikbaar.

Conclusie

De keuze tussen zelf doen of uitbesteden is gebaseerd op het volume, de gewenste data kwaliteit en de beschikbaarheid en kennis van medewerkers. Als data kwaliteit, continuïteit en volume belangrijk zijn, dan ligt het in de lijn om te kiezen voor het inkopen van data.

CONTACT